La Moral Machine est un programme informatique né de l’imagination de Jean-François Bonnefon, directeur de recherche au CNRS, enseignant à la Toulouse School of Economics et chercheur au paradis des geeks du monde entier, le Massachusetts Institute of Technology (M.I.T.).

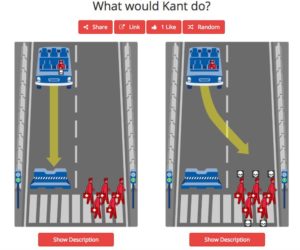

Son but : aider l’humanité à résoudre un dilemme moral surgi des nouvelles technologies. On le sait, lorsqu’une voiture autonome ne peut éviter l’accident, il pourra dans certains cas lui rester quelques millisecondes pour décider, par exemple, d’épargner son conducteur… quitte à sacrifier un piéton. Que doit-elle faire ? L’interrogation est sans fond. La réponse la plus simple, et la plus courante, consiste à privilégier la solution faisant le moins de victimes au total. Mais la réalité ne sera pas si simple : pour sauver un couple de vieillards, la voiture doit-elle sacrifier un enfant ? Faut-il sauver un groupe d’adolescents ivres, quitte à sacrifier une femme enceinte… Même si elle traversait au rouge ? Les populations accepteront-elles de telles conséquences à une décision politique ou industrielle ?

L’avis du monde

Pour résoudre la question donc, Jean-François Bonnefon et deux de ses collègues ont décidé de programmer la Moral Machine (en américain), ou Machine Morale (en français). L’idée : recueillir les réponses de dizaines de milliers d’internautes, dans le monde entier, à ces questionnements moraux. Non pas pour trouver LA réponse unique, si tant est qu’il y en ait une (ou qu’elle puisse être le fruit d’un sondage, aussi perfectionné soit-il). Mais pour éclairer les décisions des politiques comme des constructeurs, en sachant quelle est la perception des citoyens et consommateurs.

De ce travail est sortie, étonnamment, une plongée philosophique fascinante dans les sentiments des populations du globe. Car les réponses varient selon les cultures, et selon des directions assez nettes. PostAp a voulu en savoir plus sur ce sondage inédit dans la psyché de l’humanité, en allant à la source pour rencontrer l’architecte du projet.

PostAp Mag. Comment est née l’idée de la Machine Morale ?

Jean-François Bonnefon. Au départ, on a remarqué que les premières études sur le sujet concluaient systématiquement qu’il fallait faire le moins de victimes possibles. Et on a eu le pressentiment que, si l’on étudiait des scénarios plus divers, plus en détail, on risquait fort de tomber sur de nouvelles apories. On s’est vite rendu compte que si l’on commençait à décrire chaque victime de l’accident avec une demie-douzaine de variables, sur l’âge des individus, leur santé, leur comportement, on arrivait rapidement à des millions, voire des milliards de scénarios possibles. Donc tellement de possibilités qu’il n’y aurait pas suffisamment de personnes sur Terre pour répondre à un questionnaire idéal, si l’on pouvait seulement le concevoir.

C’est pourquoi, en décembre 2015, avec mes collègues du M.I.T. Iyad Rahwan et Azim Shariff, nous avons pensé créer une plateforme internet, qui permettrait de donner au projet un aspect plus engageant, et plus viral, qu’une étude statistique classique, dans le but d’obtenir un grand nombre de réponses. Pour cela, il a fallu concevoir un programme informatique qui gèrerait les questions et les scénarios de manière efficace. Cela nous a imposé de faire des choses dont les chercheurs n’ont pas toujours l’habitude. Par certains côtés, à ses débuts, le projet tenait plus de la start-up que du projet scientifique traditionnel : il a fallu s’intéresser au branding du projet, à l’expérience utilisateur, s’adresser à des consultants en viralité…

Au final, nous avons décidé de concevoir le site en amont d’un premier article sur la question pour Science, dans lequel figurerait un lien vers la Moral Machine. Mais le véritable catalyseur a été YouTube : très vite, beaucoup de gens se sont filmés en répondant au questionnaire. On dénombre des milliers de vidéos, dont certaines vues des millions de fois. Quand, par exemple, le YouTubeur PewDiePie, qui comptait une cinquantaine de millions d’abonnés à l’époque, a fait une vidéo où il tentait l’expérience, on a évidemment vu arriver du trafic.

P.M. Les YouTubeurs faisaient partie de la stratégie de viralité de départ, ou c’est arrivé naturellement ?

J-F. B. On a été complètement pris de court. Avec du recul, je me rends compte que YouTube est effectivement le meilleur moyen mais, au départ, on avait plutôt privilégié Facebook ou Twitter, en insérant dans l’expérience une sorte de profil moral de l’utilisateur, calculé d’après ses réponses.

Ce profil est une imperfection totale, car avec seulement treize réponses, on ne pouvait rien obtenir de très probant. Il n’avait pas à nos yeux de valeur scientifique : il était avant tout conçu pour être partagé sur les réseaux sociaux… ce qui a très bien fonctionné.

P.M. Vous vous étiez fixés un nombre minimum de participants en démarrant le projet ?

J-F. B. Pas du tout. Je me souviens encore du mail de l’un d’entre nous disant aux autres : « On a 50 000 réponses, c’est énorme ! » (on en est désormais à 39 millions de décisions, NDLR).

P.M. Comment avez-vous financé le projet ?

J-F. B. À part mon salaire, le M.I.T. a tout financé. Il réagissait de façon assez spectaculaire lorsque nous avions une demande urgente. Je me rappelle par exemple du jour où Moral Machine a fait la première page de Reddit, sans doute le plus gros site en langue anglaise de partage de contenu qui ne soit pas strictement un réseau social : on a vu arriver tellement de gens que l’on avait plus assez de bande passante, ni de suffisamment de stockage de données, pour les accueillir. Dans ce genre de situations, ils nous faisaient quasiment des chèques en blanc.

P.M. Qu’est Moral Machine, au fond, la Machine elle-même ? Une intelligence artificielle ?

J-F. B. Ce n’est pas une intelligence artificielle, non. C’est un algorithme qui génère des scénarios, en l’occurence 26 millions de scénarios différents, que l’on actualise constamment.

Quand la Terre cause

P.M. Les scénarios proposés comptent de nombreux personnages : enfants, personnes âgées, médecins, etc. Comment est-ce-que vous avez choisi les archétypes à faire intervenir ?

J-F. B. Il y avait des choses évidentes comme l’âge. On voulait des bébés, des enfants, des adultes, des personnes âgées. On a également différencié les sexes, essentiellement par souci de représentation des pictogrammes représentant les individus.

Il nous a été beaucoup reproché d’avoir représenté des sans-abris ou des personnes en surpoids, en nous accusant d’encourager l’ostracisme ou la grossophobie. Mais en réalité, nous l’avons fait précisément afin de montrer pourquoi il ne faudrait pas appliquer les résultats de Morale Machine de manière aveugle. Nous avons choisi, à dessein, des images un peu provocantes, comme celle du sans-abri, parce que l’on s’attendait à ce qu’il y ait de la discrimination à son égard. Ces exemples nous ont permis d’appuyer le propos central de l’expérience : il ne s’agit pas d’un référendum pour trouver la réponse définitive à comment programmer les voitures autonomes, mais plutôt d’une base de travail. Le but, c’est de recueillir les préférences de la population. Certaines sont inapplicables, illégales et parfois immorales : c’est pourquoi Moral Machine non seulement ne doit pas, mais même ne peut pas être perçue comme une autorité indépendante et sage, qui aurait réponse à tout.

D’autres personnages avaient vocation à apporter de la diversité dans les scénarios, pour que les gens ne s’ennuient pas trop. Le criminel masqué et son sac de billets, par exemple, était plutôt destiné à offrir une respiration pendant le questionnaire qu’à être analysé ensuite.

P.M. Quand avez-vous estimé avoir recueilli suffisamment de résultats pour les examiner en détail ?

J-F. B. Lorsque l’on a vu, après 18 mois, que l’on approchait des 40 millions de réponses, on s’est dit que c’était peut-être le bon moment. On commençait aussi à être pas mal sous pression des journalistes, et d’une manière générale de pas mal de personnes qui attendaient les résultats… Lorsque l’on s’est aperçu que les réponses arrivaient de tous les pays du monde, on a recruté deux anthropologues pour analyser les données culture par culture, pays par pays.

P.M. Quelles sont les premiers éléments que vous avez remarqués et interprétés ?

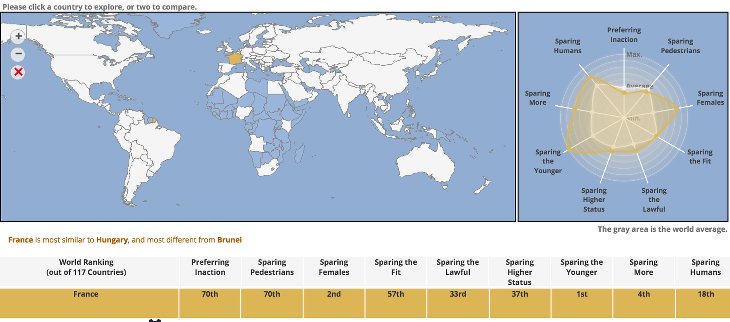

J-F. B. En analysant les 40 millions de données, on a distingué plusieurs grandes masses, au premier chef les trois raisons principales de sauver les potentielles victimes : épargner les humains plutôt que les animaux, épargner le plus grand nombre de personnes et épargner les plus jeunes.

Ensuite, on a relevé des critères d’une importance modérée, comme le respect des feux rouges et des feux verts, et enfin les questions plus problématiques comme les sans-abris et les personnes en surpoids, qui se situaient dans cette même zone du milieu.

P.M. C’est-à-dire comme les personnes qui traversent au rouge ?

J-F. B. Oui.Dans nos données, c’est comme si le sans-abri était quelqu’un qui traversait systématiquement au rouge… Avec toutefois de grosses variations d’un pays à l’autre. Un autre critère important, du moins le croyait-on, consistait à savoir si la victime se trouvait devant la voiture ou non : beaucoup de psychologues pensaient que dans l’esprit des gens, il valait mieux « laisser faire » dans ces cas sinistres, plutôt que d’agir, et qu’il s’agirait d’un critère déterminant. En réalité, cela s’est avéré, aux yeux du public, l’un des points les moins importants relevés par Moral Machine.

En fait, les préférences ont toutes pris la même direction, quelles que soient régions du monde. Les sans-abris sont plus sacrifiés dans tous les pays, les enfants sont épargnés partout. Ensuite, le poids de la préférence varie d’un pays à l’autre. De la même façon, les femmes sont globalement plus préservées. Faiblement dans certains pays, et de façon plus importante dans d’autres, mais toujours dans le même sens.

Or, si le fait de distinguer un humain d’un animal, de compter des personnes, ou de repérer s’il s’agit d’enfants sont trois critères que des voitures autonomes peuvent prendre en compte, elles sont incapables de distinguer la différence de genre ou de classe sociale. Il est donc intéressant de constater que le top 3 correspond à des décisions techniquement réalisables. Autre point notable : les résultats ont fait écho à une commission éthique du ministère des transports allemand sur les voitures autonomes. Elle était d’ailleurs la première en son genre, et s’est créée pendant que l’on collectait les données de Morale Machine.

Ses recommandations consistaient à sauver les humains plutôt que les animaux, mais ses participants n’ont pas réussi à se mettre d’accord sur la question du nombre de victimes, en indiquant qu’il serait peut-être préférable, sur ce sujet, de laisser le libre-choix aux constructeurs. À l’inverse, nos résultats font état d’une préférence assez massive de l’opinion publique pour sauver le plus grand nombre.

La commission avait en outre préconisé l’interdiction de sauver les enfants en premier, et de façon générale de sélectionner les victimes selon des caractéristiques individuelles, arguant qu’une vie vaut une vie. Or, le sujet des enfants venait en troisième point de Moral Machine, donc crucial pour les sondés et les sondées, quand cette commission éthique considère que c’est un critère inacceptable.

P.M. C’est peut-être le moment de redire que votre but n’est pas de trouver une réponse, mais plutôt d’éclairer les gouvernements et les constructeurs qui auront, eux, à prendre des décisions…

J-F. B. Exactement. Même si la situation sera extrêmement rare, il faudra bien à un moment se décider. Or nous n’avons pas la prétention de prendre les décisions, mais plutôt de faire état de l’opinion publique de chaque pays sur la question, pour aider les décisionnaires futurs.

P.M. Vous avez identifié trois zones culturelles fortes —l’Occident, l’Asie et le Sud— dont la façon d’envisager la question semble assez différentes… Pouvez-vous nous dire en quoi ?

J-F. B. Lorsque l’on a demandé à l’algorithme de trouver les pays dont les réponses sont très proches, il a formé un paquet très resserré avec toutes les anciennes colonies britanniques. L’Angleterre, les États-Unis, le Canada, l’Australie, la Nouvelle-Zélande, l’Afrique du Sud, tous dans un mouchoir de poche. C’était assez spectaculaire, pour des pays qui ont eu des trajectoires si différentes, de constater que l’héritage britannique induisait des réponses à Morale Machine presque identiques d’un pays à l’autre. On assistait là à quelque chose d’assez excitant. La France ne figure pas dans ce cluster largement occidental : sur ces questions morales, les Sud-Africains par exemple on plus de points communs avec l’Angleterre que cette dernière n’en a avec l’Hexagone.

On trouve ensuite un paquet regroupant les pays asiatiques et le Moyen-Orient, soit beaucoup de pays confucéens et musulmans. Là aussi, cela est assez remarquable…

Puis le paquet Sud, où l’on trouve l’Amérique latine, et de nombreux pays africains et de l’hémisphère sud, ainsi que la France, avec ses territoires d’outre-mer, mais aussi des pays, comme l’Algérie et le Maroc, qui ont un jour été sous influence française. Une question intéressante s’est donc posée sur la place de la France dans le bloc de l’Amérique du Sud, plutôt que dans celui de l’Occident. On soupçonne la forte influence, historique, du droit français sur le droit sud-américain, pour expliquer les similitudes de ces pays éloignés dans leurs réponses à Morale Machine.

P.M. Quelles différences observe-t-on entre ces trois blocs ?

J-F. B. Elles sont très nombreuses… Pour ne donner que quelques exemples : la préférence pour sauver les enfants est plus faible dans le cluster asiatique ; toute différence entre les enfants et les personnes âgées y est d’ailleurs moins marquée. À l’inverse, dans le monde franco-latin, la préférence pour sauver les femmes est nettement plus haute que la moyenne mondiale.

P. M. Ces résultats étaient attendus ? Vous attendiez-vous même seulement à trouver des différences aussi nettes ?

J-F. B. Après avoir établi ces clusters et leurs différences, on a fait beaucoup de recherches pour essayer de les comprendre, notamment les corrélations entre des variables socio-économiques à l’échelle du pays et les décisions des gens sur Morale Machine. Nous avons pu établir par exemple que de fortes inégalités économiques dans un pays induisent plus de sans-abris sacrifiés dans nos questionnaires. Dans le même esprit, le fait de sacrifier les piétons qui traversent au rouge est très corrélé avec la force des institutions et de la loi dans certains pays. Plus les gens ont l’habitude d’en voir d’autres enfreindre la loi sans être punis, plus ils sont tolérants avec les piétons qui traversent au rouge.

C’est là que l’apport des sciences humaines s’est avéré le plus utile. On entrait les données morales de chaque pays, l’algorithme ne connaissant évidemment pas leur position, et lorsqu’il regroupait des paquets, les anthropologues nous confirmaient qu’ils avaient du sens. Ils ont pu nous décrire les caractéristiques culturelles les plus importantes des clusters que l’on avait identifiés et nous indiquer quelles variables pouvaient expliquer les différences entre ces clusters. S’intéresser au poids légal des institutions ou au taux de survie des embryons féminins par pays sont, par exemple, des choses qui ne s’inventent pas.

Par-delà le Bien et le Mal

P. M. J’imagine que le projet continue ? Il est amené à évoluer ?

J-F. B. On a bien sûr beaucoup d’idées sur ce que l’on pourrait faire avec les données… mais ce qui nous excite le plus est de savoir ce que les autres vont en faire. Car tous les résultats sont en accès libre, ils peuvent donc bénéficier à quiconque manque de données quantitatives pour tester une théorie. On est sûr que certains seront très créatifs. Notre travail va également consister à les expliquer, car même en libre accès, ces résultats restent très compliqués à aborder. Nous serons donc disponibles pour parler avec les pouvoirs publics ou les constructeurs qui aimeraient mieux les comprendre.

De plus, Moral Machine continue à tourner, ce qui signifie que l’on a un moyen de suivre l’évolution de l’opinion. Lorsqu’un évènement se se produira quelque part dans le monde, on pourra donc mesurer son impact sur les réponses.

P. M. Le nom de Morale Machine est très bien choisi, sans doute volontairement provocateur. J’imagine qu’il a été bien réfléchi ?

J-F. B. Si vous saviez le nombre de noms que l’on a passés en revue… ! Je ne vous dirais pas les pires ni les meilleurs : je les garde pour le livre que j’écris sur cette histoire. Mais avec un peu de recul, je me rends compte qu’on est passé par des phases particulièrement stupides !

P. M. Une dernière question : le M.I.T. est un lieu assez fantasmatique pour toutes les personnes qui s’intéressent au futur… Et c’est notre cas ! Quelle impression vous a-t-il laissé ?

J-F. B. La magie de la première fois fonctionne complètement. Le campus s’étale sur une bonne partie de Cambridge, il y a énormément de bâtiments… Surtout, j’ai eu la chance de travailler au MediaLab, qui est un endroit extraordinaire de la structure, c’est ce qu’il y a de plus beau. Le MediaLab n’a rien à voir avec les médias, on y trouve de tout. Des spécialistes de toutes les disciplines y discutent et créent des choses ensemble. Ainsi, à gauche de mon bureau, une équipe réfléchit à l’éthique de l’augmentation génétique ; plus bas on trouve une salle de test pour les prothèses robotiques de jambes… C’est vraiment l’endroit où les gens essayent d’imaginer le futur. C’est passionnant de les voir s’exercer à cela !

Vous voulez passer le test de la Machine Morale ? C’est par ici !

Vous préférez vous pencher directement sur les résultats ? C’est par là !

Un grand merci à Jean-François Bonnefon et Augustin Le Goaster pour leur disponibilité.